Changelog

Wir arbeiten ständig an neuen Funktionen und Verbesserungen. Entdecke hier, was es Neues gibt:

Neue GPT-4o Version

Die neueste Version von GPT-4o ist jetzt auf der Plattform verfügbar und bringt verbesserte Antwortqualität sowie schnellere Reaktionszeiten mit sich! 🚀

Zur Vereinfachung wurden die bisher getrennten Versionen "GPT-4o (latest)" und das reguläre "GPT-4o" zusammengeführt. Bei der Auswahl von "GPT-4o" wird nun automatisch die aktuellste Version bereitgestellt.

Die GPT-4o Bildgenerierungsfunktion, die vor einigen Tagen angekündigt wurde, ist aktuell noch nicht auf EU-Servern verfügbar. Wir werden diese Funktionalität hinzufügen, sobald dies der Fall ist.

Darüber hinaus wurden folgende oft gewünschte Verbesserungen vorgenommen:

- Formatierung beim Kopieren: Beim manuellen Kopieren von Textpassagen aus Chat-Antworten und Assistenten bleibt die Formatierung nun erhalten – genau wie beim Verwenden der Kopier-Funktion

- Native Mermaid-Diagrammunterstützung: Mermaid-Diagramme können nun direkt in unserem Chat erstellt werden. Dazu zählen Flussdiagramme, Sequenzdiagramme und viele mehr

- o3 mini via API: OpenAI's o3 Mini Reasoning-Modell ist jetzt über unsere API verfügbar

- Tabellenformatierung: Wir haben die Formatierung von Tabellen im Chat verbessert. Dies umfasst das Erscheinungsbild, das Kopierverhalten und die Möglichkeit, eine CSV der generierten Tabellen herunterzuladen

Neue Integrationen

Wir haben unsere neuen Integrationen gelauncht! Es ist jetzt viel einfacher, andere Software-Tools in Langdock zu integrieren, um Information abzurufen und Aktionen auszuführen. Das Update besteht aus drei Hauptteilen:

- 20+ native Integrationen sind ab sofort in Langdock verfügbar

- Integrationen für eure eigenen Tools können jetzt viel einfacher erstellt werden

- Verbesserungen bestehender Integrationen und Wissensordner

Neue Integrationen und Aktionen

Wir haben die Integration externer Tools in eure Assistenten erleichtert und viele neue Integrationen für die Tools gebaut, die unsere Kunden nutzen. Zum Beispiel könnt ihr jetztdie folgenden Integrationen nutzen: Jira, HubSpot, Google Sheets, Excel, Outlook, Google Kalender und Google Mail.

Damit könnt ihr Aktionen hinzufügen, die eure Assistenten ausführen können. Zum Beispiel:

- Schreiben von E-Mail-Entwürfen und Senden an Google Mail oder Outlook

- Erstellen oder Aktualisieren von Deals in HubSpot

- Schreiben und Aktualisieren von Tickets in Jira

- Einen Eintrag in ein Google Sheet oder ein Excel Sheet hinzufügen

- Eine Nachricht in einem Microsoft Teams-Chat senden

- Und viele mehr...

Hier findet ihr weitere Details zur Nutzung. Wenn euch eine Integration oder eine spezifische Aktion fehlt, lasst es uns gerne wissen!

Eigene Tools integrieren

Das Langdock-Team wird in den kommenden Wochen Integrationen zu allen Standardsoftware-Tools erstellen. Wenn wir (noch) keine Integration haben oder ihr ein internes Tool integrieren möchtet, könnt ihr eure eigenen Integrationen erstellen.

Wir haben die vorherigen OpenAPI-Schema-basierten Integrationen mit einem einfacheren Integrations-Builder ersetzt. Dieser ermöglicht es auch, eigenes JavaScript zu schreiben, um alle Arten von Sonderfällen abzudecken. Die Integrationen/Aktionen leben jetzt außerhalb der Assistenten, sodass ihr sie in mehreren Assistenten teilen und wiederverwenden könnt. Ihr könnt diesem Guide folgen, um eure eigenen REST-API-basierten Integrationen einzurichten.

Verbesserungen bestehender Integrationen und Wissensquellen

Wir haben auch die Oberfläche und das Nutzung bestehender Integrationen verbessert. Hier sind die wichtigsten Änderungen:

- Wenn ihr ein Dokument von einer Integration (z.B. SharePoint oder Google Drive) als Assistentenwissen anhängt, aktualisieren wir jetzt den Inhalt des Dokuments alle 24 Stunden. Dies stellt sicher, dass ihr immer mit der neuesten Version des Dokuments in euren Langdock-Assistenten arbeitet. Ihr könnt ein Dokument auch jederzeit manuell aktualisieren.

- Wissensordner können jetzt mit Nutzern, Gruppen und dem Workspace geteilt werden (ähnlich wie Assistenten). Die Wissensordner wurden von den Kontoeinstellungen in das Integrationsmenü verschoben, um sie sichtbarer zu machen.

- Wenn ihr bereits eigene Aktionen in einem Assistenten erstellt habt, sind diese weiterhin für einige Zeit verfügbar. Diese sind als read-only markiert, da sie am 30. April eingestellt werden. Wir empfehlen, eure bestehenden Aktionen auf unsere neuen, verbesserten Aktionen zu migrieren. Wenn eure Aktion noch nicht sofort verfügbar ist, lasst es uns wissen, wenn ihr Hilfe bei der Migration benötigt.

- Vektordatenbanken wurden ebenfalls von individuellen Assistenten in das Integrationsmenü verschoben, um die Wiederverwendung von Verbindungen zu diesen zu erleichtern. Assistenten mit bestehenden Vektordatenbanken wurden entsprechend migriert, um sicherzustellen, dass sie wie zuvor funktionieren.

Zusätzliche Informationen für Workspace-Admins:

- Standardmäßig sind alle Integrationen aktiviert. Ihr könnt hier konfigurieren, welche Integrationen in eurem Workspace aktiviert werden sollen.

- Workspace-weite Integrationen (Google Drive & Confluence über Service Accounts) sind jetzt zugunsten der neuen Integrationen eingestellt. Bitte informiert eure Nutzer, damit sie die Integrationen manuell konfigurieren können. Die Funktionen und Berechtigungen sind komplett über die neuen Integrationen abgedeckt.

- Die Berechtigungen pro Nutzerrolle haben sich geändert, um das neue Integrations-Framework abzubilden: Die Berechtigungen „Vektordatenbanken verbinden“ und „Aktionen verbinden“ wurden entfernt, und die neuen Berechtigungen sind „Wissensordner teilen“ und „Integrationen erstellen“.

Diese neuen Integrationen werden viele weitere Use Cases in Langdock ermöglichen, und dieses Update ist erst der Start. In den kommenden Wochen werden wir viele weitere Funktionen hinzufügen, um mit allen möglichen Arten von Daten in Langdock zu arbeiten. Mehr dazu bald!

Geschwindigkeitsverbesserungen

Wir haben umfangreiche Geschwindigkeitsverbesserungen auf unserer gesamten Plattform erreicht! Während wir kontinuierlich an der Antwortgeschwindigkeit der Modelle arbeiten, haben wir jetzt dafür gesorgt, dass alles andere auch viel schneller läuft. Außerdem haben wir einige oft angefragte Verbesserungen an unserer Chat-Eingabe und API veröffentlicht.

- Embedding Modelle in der API: Das OpenAI ada-002 Embedding Modell ist jetzt über unsere API verfügbar und kann für die Personalisierung, Empfehlung und Suche von Inhalten verwendet werden

- Wissensordner + Assistenten-API: Wissensordner sind jetzt vollständig auch mit der Assistenten-API nutzbar

- Anzeige der Zeichenzahl: Das Texteingabefeld bietet jetzt bei Überschreitung der Zeichengrenzen eine visuelle Rückmeldung, die die Zeichenzahl anzeigt und das Feld rot einfärbt

Claude 3.7 Sonnet, o3 Mini und Gemini 2.0

Wir haben drei leistungsstarke neue Modelle zu Langdock hinzugefügt: Claude 3.7 Sonnet, OpenAI's o3 Mini und Gemini 2.0 Flash.

Claude 3.7 Sonnet

Claude 3.7 Sonnet ist der Nachfolger von 3.5, einem der meistgenutzten Modelle in unserer Plattform. Die vorherige Version 3.5 wird bereits von vielen Nutzern für Schreibaufgaben wie E-Mails oder Übersetzungen und für Programmierung verwendet.

Die Besonderheit des Modells sind zwei verschiedene Modi, die als verschiedene Modelle in der Modellauswahl wählbar sind:

- Der erste Modus ermöglicht es Nutzern, das Modell als reguläres LLM agieren und für einfachere Aufgaben sofort die Antwort zu generieren (zum Beispiel E-Mails schreiben oder Texte zu übersetzen).

- Der Reasoning Modus kann vom Modell genutzt werden, um vor der Antwortgenerierung zu reflektieren, um eine bessere und tiefere Antwort für komplexe Probleme zu finden (zum Beispiel Strategie oder Mathematik).

Wir haben die Modi als zwei separate Modelle hinzugefügt(Claude 3.7 Sonnet und Claude 3.7 Reasoning).

o3 Mini

o3 Mini ist das neueste und effizienteste Modell der Reasoning-Serie von OpenAI.

Es verwendet wie o1, r1 von DeepSeek oder das oben erwähnte Claude 3.7 Sonnet Modell Chain-of-Thought-Denken, um eine Aufgabe in mehrere Schritte zu unterteilen. Dies macht die Modelle nützlich für komplexe Aufgaben wie Mathematik, Physik, komplexe Anweisungen, Programmierung oder komplexe strategische Aufgaben.

o3 Mini ist das neueste und effizienteste von OpenAls Reasoning Serie. o1 ist das generellere Reasoning Modell und o3 Mini st schneller im Vergleich dazu. Da o3 Mini es ermöglicht, den Reasoning Aufwand zu kontrollieren, haben wir sowohl den Standard als auch den erweiterten Reasoning Modus als zwei verschiedene Modelle hinzugefügt (o3 Mini and o3 Mini High).

Gemini 2.0 Flash

Wir haben auch das neue Gemini 2.0 Flash Modell hinzugefügt, das jetzt auch in der EU verfügbar ist. Das Flash-Modell der vorherigen Gemini 1.5 Generation war das schnellere, kleinere Modell im Vergleich zum größeren und fortschrittlicheren Gemini 1.5 Pro. Das neue Gemini 2.0 Flash übertrifft Gemini 1.5 Pro bei wichtigen Benchmarks und ist dabei doppelt so schnell.

Assistenten-Formulare

Wir führen eine neue Art der Interaktion mit Assistenten bei Langdock ein: Assistenten-Formulare. Beim Erstellen eines Assistenten können Assistentenersteller jetzt die neue Eingabemethode über Formulare wählen, bei der sie die Eingabefelder definieren können, die den Nutzern angezeigt werden.

Ihr könnt ein Interface erstellen, um die Nutzereingaben zu strukturieren, um qualitativ hochwertige Ergebnisse zu erhalten - ähnlich wie bei Umfrageformularen. Wenn Benutzer einen Assistenten mit der neuen Eingabemethode verwenden, wird ihnen das Formular angezeigt, das der Assistentenersteller konfiguriert hat. Ihr könnt Eingaben verwenden, die ihr von anderen Tools kennt, wie:

- Einzeiliger Text

- Checkboxen

- Datei-Upload

- Dropdown-Auswahl

- Zahlen

- Datum

Dies gibt den Erstellern von Assistenten mehr Flexibilität bei der Erstellung von Assistenten und ermöglicht es ihnen, die Eingabestruktur auf Ihre spezifischen Bedürfnisse zuzuschneiden, während es für andere Benutzer einfacher wird, den Assistenten zu verwenden.

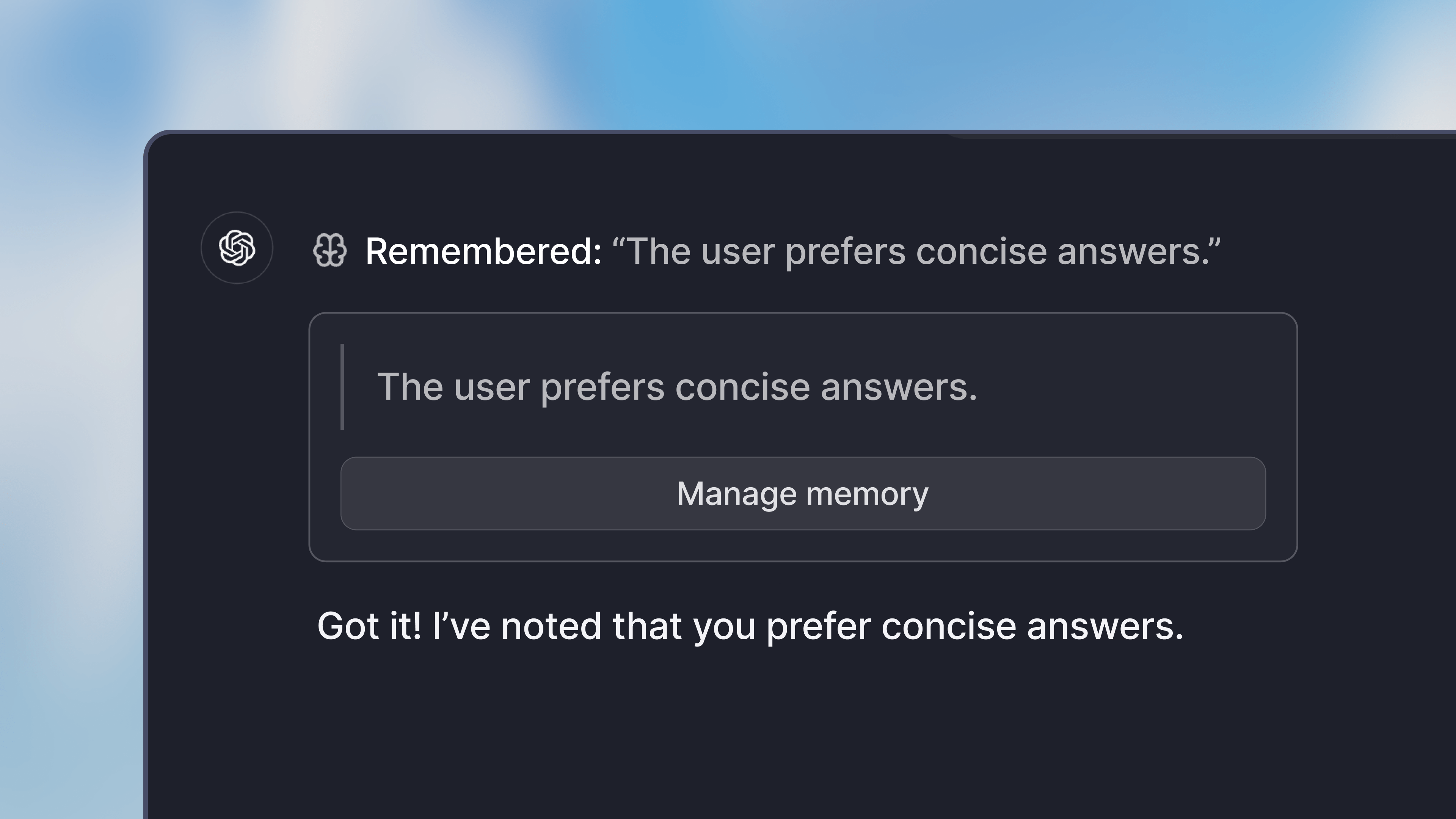

Erinnerung

Das Erinnerungs-Feature ermöglicht eine tiefere Personalisierung der Modellantworten, da Informationen aus früheren Interaktionen in der Applikation gespeichert werden können.

Wenn du Erinnerungen verwendest, kannst du das Modell anweisen, bestimmte Informationen über dich, deine Arbeit oder deine Präferenzen in der Applikation zu speichern. Du kannst zum Beispiel anweisen:

- Sich an bestimmte Aufgaben deines Jobs zu erinnern

- Sich eine Vorliebe für einen bestimmten Schreibstil merken.

- Sich deinen Namen und andere persönliche Informationen merken

Das Erinnerungs-Feature ist standardmäßig deaktiviert. Um es zu verwenden, gehe zu den Präferenzen in den Einstellungen. Dort kannst du die Funktion im Abschnitt „Fähigkeiten“ aktivieren.

Alle Erinnerungen werden in deinem Profil gespeichert und stehen dann in allen Chats (nicht in Chats mit Assistenten) zur Verfügung. Sie sind für andere Nutzer in deinem Workspace nicht zugänglich.

- OpenAI o3 mini: Wir haben das neue OpenAI o3 mini Modell hinzugefügt. Admins können es in den Einstellungen konfigurieren. Wir beziehen das Modell von Microsoft Azure (global Standard).

- Erhöhung der Passwortanforderungen: Wir haben die Mindestanzahl an Zeichen erhöht, die ein Passwort haben muss. Wir empfehlen die Verwendung eines Passwort-Managers, den Magic-Email-Link-Login oder den Login über SSO.

- Langfuse Integration: Wir haben eine Langfuse-Integration hinzugefügt, die es technischen Nutzern ermöglicht, die Performance von Assistenten zu analysieren.

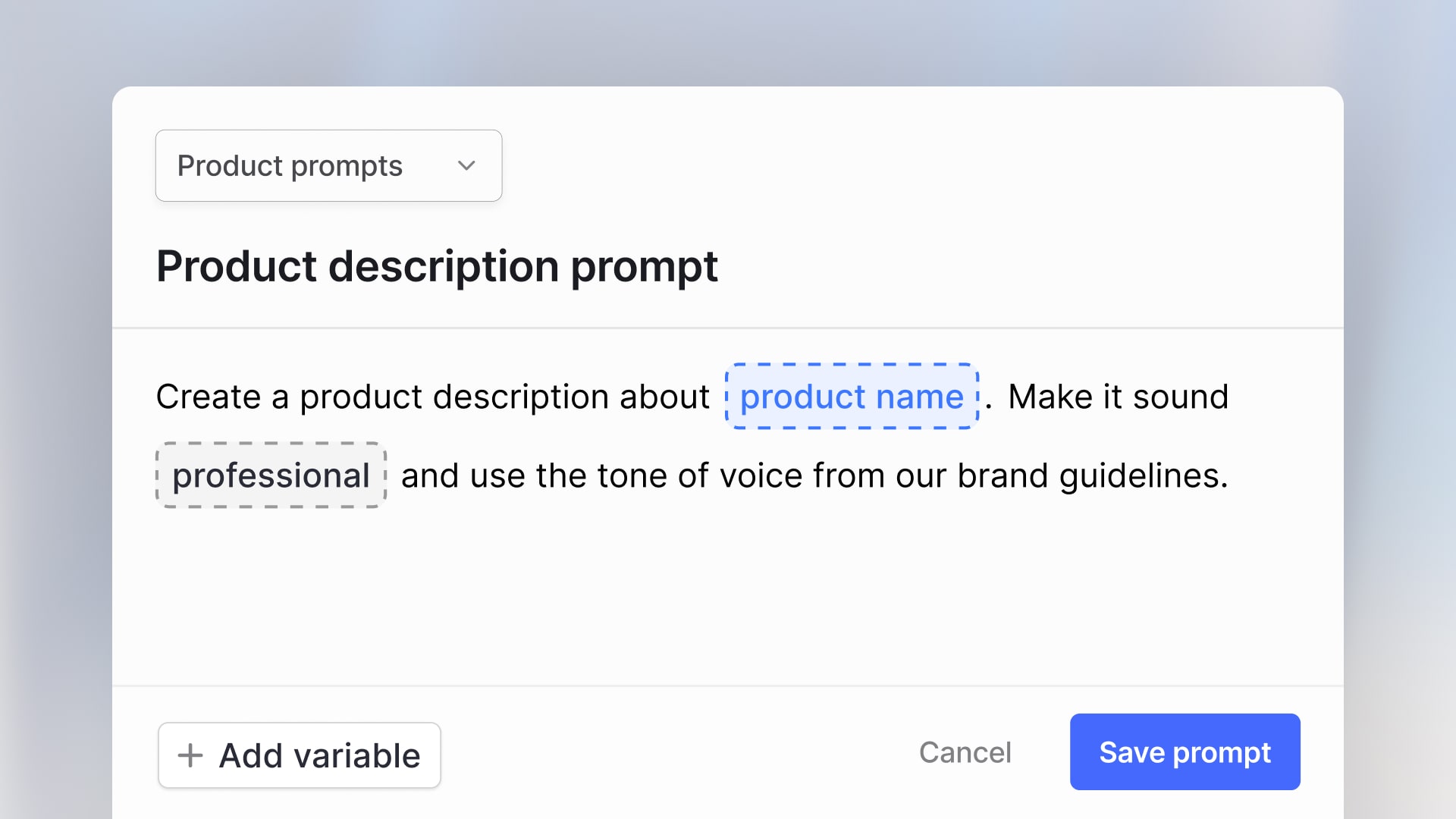

- Prompt-Variablen: Wir unterstützen jetzt die mehrfache Verwendung derselben Variable in Prompts.

DeepSeek R1

Langdock unterstützt jetzt das neue R1-Modell des chinesischen KI-Unternehmens DeepSeek hinzugefügt. R1 hat viel Aufmerksamkeit in den Medien für die starke Leistung erhalten. Das Modell ist vergleichbar mit der o1-Serie des Konkurrenten OpenAI.

Das R1-Modell ist in verschiedenen Versionen verfügbar. Wir hosten die 32B-Version auf unseren eigenen Servern in der EU und nutzen die volle 671B-Version von Microsoft Azure in den USA. Da das Modell noch sehr jung ist und sich auf Reasoning fokussiert, haben wir Tools wie Dokumentenupload, Websuche und Datenanalyse aktuell deaktiviert.

Admins können das Modell in den Einstellungen konfigurieren.

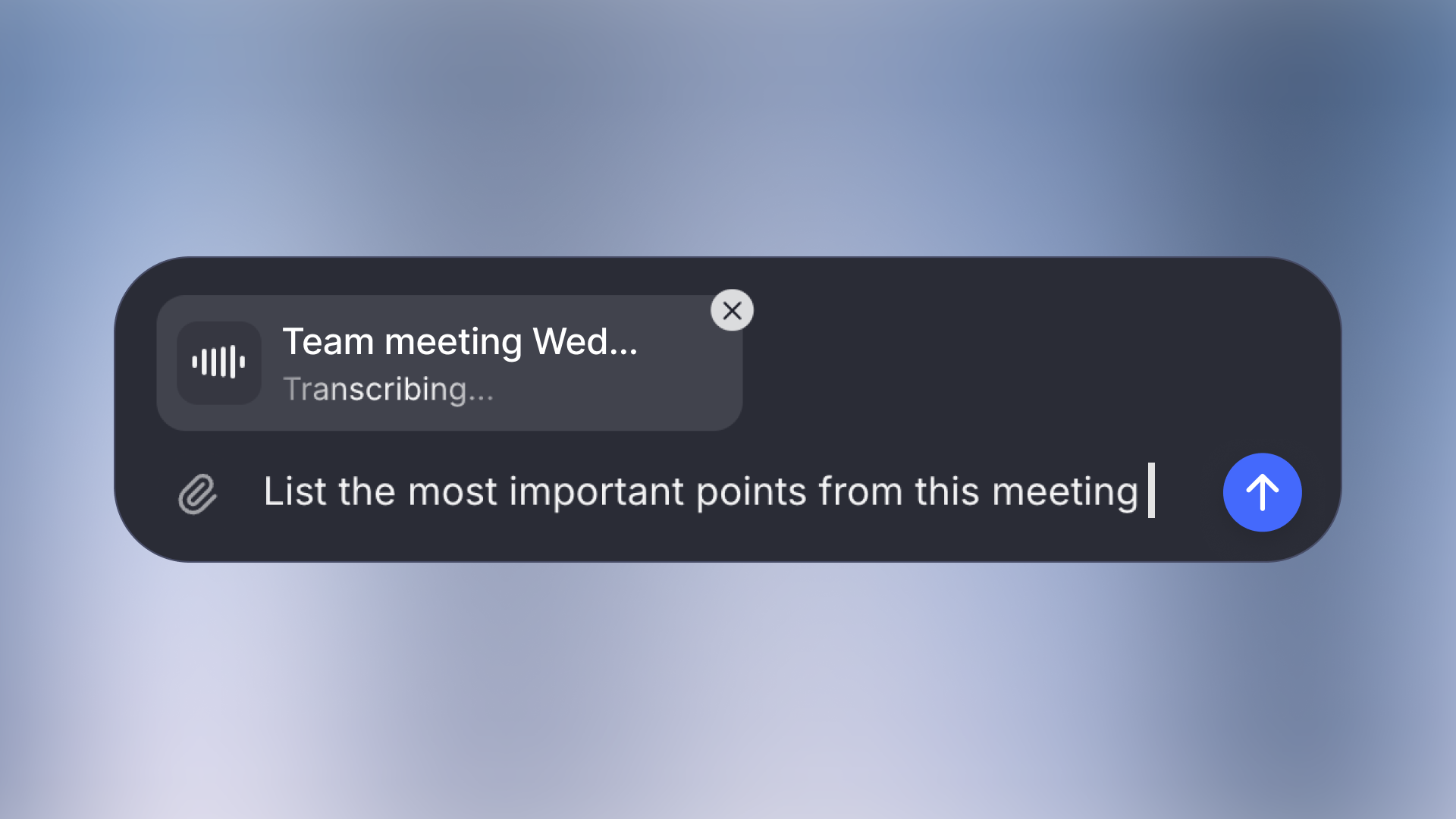

Audio & Video im Chat

Wir freuen uns, dass ihr ab sofort direkt im Chat mit Audio- und Videodateien arbeiten könnt.

Lade deine Aufnahmen (bis zu 200MB) hoch, und unser System transkribiert sie automatisch, sodass du Gespräche über den Inhalt führen kannst.

Allen gängigen Formaten wie MP4, MP3, WAV und MPEG können hochgeladen werden. Egal ob du ein Team-Meeting nachbereiten möchtest, ein Kundengespräch analysieren oder eine Sprachnotiz verarbeiten möchtest - lad einfach die Datei hoch und stelle deine Fragen zum Inhalt.

- Llama 3.3 Modell: Wir haben das neue Llama 3.3 70B Modell hinzugefügt.

- OpenAI o1: Langdock unterstützt jetzt das o1-Modell von OpenAI. Allerdings ist es nur als Global Deployment verfügbar, weshalb Anfragen potenziell auch außerhalb der EU verarbeitet werden können. Das Modell ist standardmäßig ausgeschaltet, Admins können es aber in den Modelleinstellungen aktivieren.

- Amazon Nova Modelle: Wir haben die Nova Modelle von Amazon hinzugefügt. Aktuell sind diese nur in den USA verfügbar.

- Gemini als Backbone Modell: Admins können Gemini Modelle als Backbone Modell festlegen. Das Backbone Model definiert Aufgaben im Hintergrund für einige Modelle.

Web Modus

Langdock bietet jetzt einen verbesserten Web Modus, der schnelle und aktuelle Antworten mit Links zu relevanten Quellen im Internet bietet.

Wenn in deinem Workspace Web Suche aktiviert ist, kannst du die Web Suche im neu designten Chatfeld auswählen. Dies zwingt das Modell, im Internet nach aktuellen Informationen und Neuigkeiten zu suchen.

- Kopieren einer Antwort: Nutzer können jetzt Antworten kopieren, während sie noch generiert werden.

- API Limits: Admins können in den API Einstellungen Ausgabenlimits festlegen.

- Prompt Bibliothek: Das Layout der Prompt Bibliothek wurde verbessert, um mehr Inhalte der gespeicherten Prompts zu zeigen.

- Lange Chats: Das Verhalten und Rendering von Nachrichten wurde verbessert, was zu einem besseren Verhalten in langen Chats führt.

- Datenanalyst: Wir haben einige größere Verbesserungen für den Datenanalysten gemacht, die dessen Performance verbessern.

- Hochladen von Python, HTML, CSS, JS, PHP: Du kannst jetzt weitere Dateitypen hochladen.

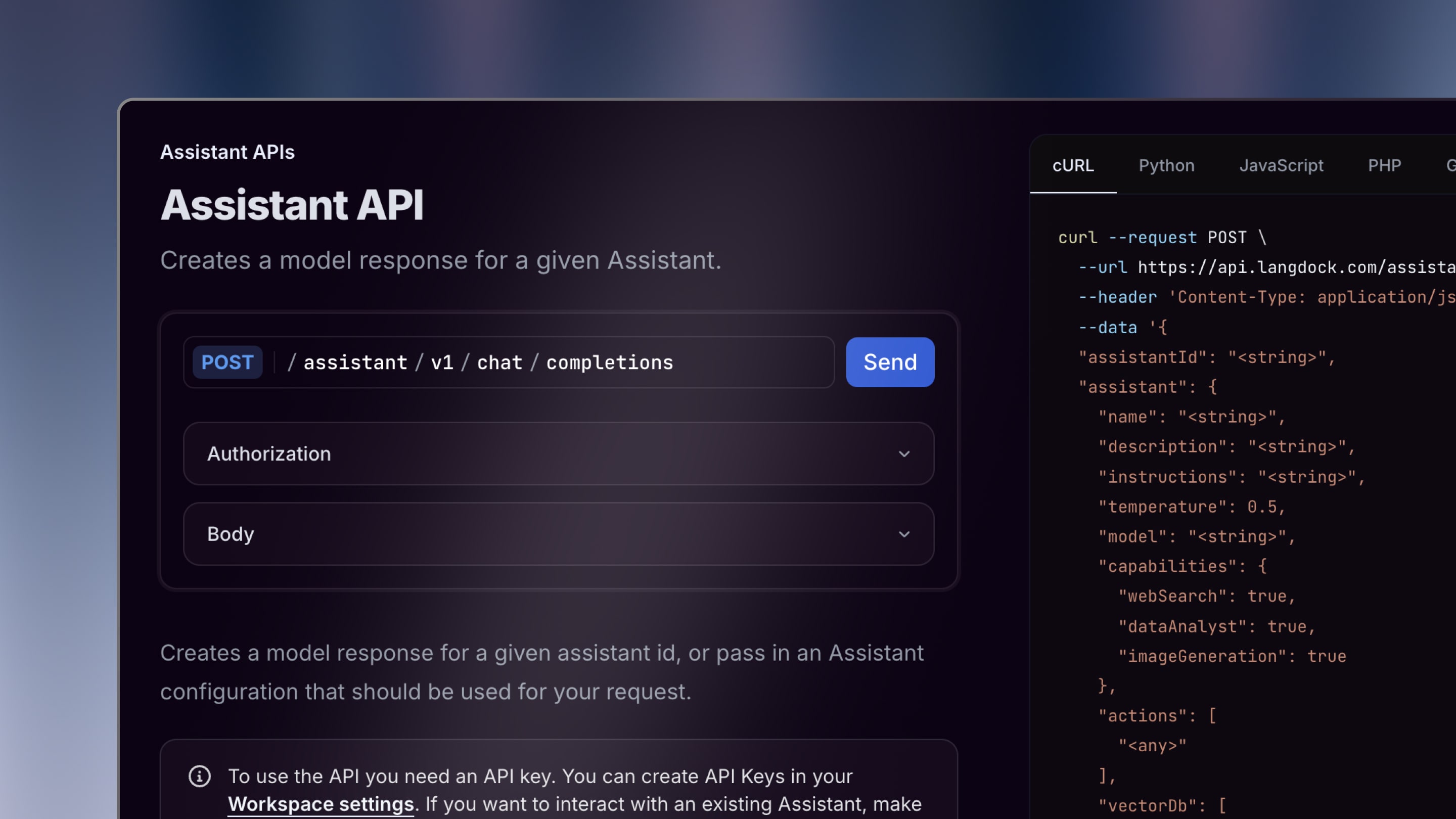

API für Assistenten

Wir haben die API für Assistenten gelauncht. Du kannst jetzt über eine API auf Assistenten zugreifen, einschließlich angehängtem Wissen und verbundenen Tools.

Um einen Assistenten über die API zugänglich zu machen, müssen Administratoren in den API-Einstellungen einen API-Key erstellen. Danach kannst du den Assistenten mit der API teilen, indem du den Key wie ein normales Workspace-Mitglied einlädst.

Nachdem du die API in deinem Workflow konfiguriert hast (hier ist unsere Dokumentation), kannst du Nachrichten über die API an den Assistenten senden. Die API umfasst auch strukturierte Ausgaben und Dokumenten-Upload.

- Formatierung von kopierten Inhalten: Wir haben die Formatierung verbessert, wenn du eine Antwort in ein anderes Tool kopierst.

- Chats teilen: Wenn ein Nutzer im Assistent-Teilen-Menü auf 'Link erstellen' klickt, wird die URL automatisch in die Zwischenablage kopiert.

- Datenanalyst: Wir haben die Verarbeitung von Excel, CSV und PDF Dateien verbessert.

- Pinecone als Vektor Datenbank: Wir haben Pinecone als unterstützte Vektordatenbank hinzugefügt.

Command Bar (Cmd+K)

Du kannst jetzt mit dem Cmd + K Feature direkt mit der Tastatur durch Langdock navigieren und Chats suchen. Dies ermöglicht noch schnelleren und einfacheren Zugriff auf alle Informationen, die du brauchst.

Wenn du Cmd + K auf deiner Tastatur drückst (für Windows Strg + K), öffnet sich ein Menü, um schnell verschiedene Aktionen auszuführen. Hier ein paar Beispiele:

- Durchsuche alle deine Chats

- Suche einen bestimmten Assistenten

- Ändere schnell Einstellungen, wie den Wechsel zum Dark Mode, öffne die Dokumentation, den Changelog oder den Support-Chat.

Wir haben auch einen Such-Button in der oberen linken Ecke hinzugefügt, mit dem ihr die Command Bar öffnen könnt.

Außerdem gibt es jetzt neue und aktualisierte Shortcuts:

- Neuen Chat öffnen: Cmd + Shift + O

- Seitenleiste öffnen/schließen: Cmd + Shift + S

- Letzte Antwort kopieren: Cmd + Shift + C

Wir hoffen diese Verbesserungen helfen euch und machen euch noch produktiver.

- Langer Text in Variablen: Die Anzeige von langem Text in Variablen wurde verbessert.

- Verbesserung der Aktionen: Es werden jetzt mehrere Header in Aktionen unterstützt.

- Weiterleitung beim Teilen von Assistenten: Beim Teilen eines Assistenten wurden Nutzer zur Assistentenübersicht weitergeleitet. Wir haben das Verhalten verbessert, sodass Nutzer nicht weitergeleitet werden und im Assistenten-Editor bleiben.

Prompt Variablen

Du kannst jetzt Variablen in deine Prompts einbauen und dynamische Vorlagen erstellen, die sich leicht in verschiedenen Kontexten wiederverwenden lassen.

Wenn du einen neuen Prompt in der Prompt Bibliothek erstellst, umschließe ein Wort mit {{ und }} oder klicke auf den Variablen-Button unten, um es zu einer Variablen zu machen. Wenn du den Prompt später verwendest, können Nutzer schnell die Variablen ausfüllen, um den Prompt an ihre Bedürfnisse anzupassen.

Diese Funktion hilft, einen Prompt noch einfacher in verschiedenen Kontexten zu verwenden, oder es anderen leichter zu machen, deinen Prompt zu nutzen, wenn du ihn teilst.

Weitere Details findest du in unserem Abschnitt über die Prompt-Bibliothek in unserer Dokumentation.

- Websuche: Die Geschwindigkeit der Websuche und Anzeige der Quellen wurde verbessert.

- Claude 3.5 Sonnet Verbesserung: Claude 3.5 Sonnet neigte dazu, häufiger als andere Modelle auf das Web zuzugreifen. Wir haben dieses Verhalten verbessert.

- Assistenten-Feedback:: Diese Verbesserung ermöglicht es Nutzern, Feedback für Assistenten ohne Freitext-Eingaben zu geben.

- API-Verbesserung: Wir haben unsere API mit n8n kompatibel gemacht.

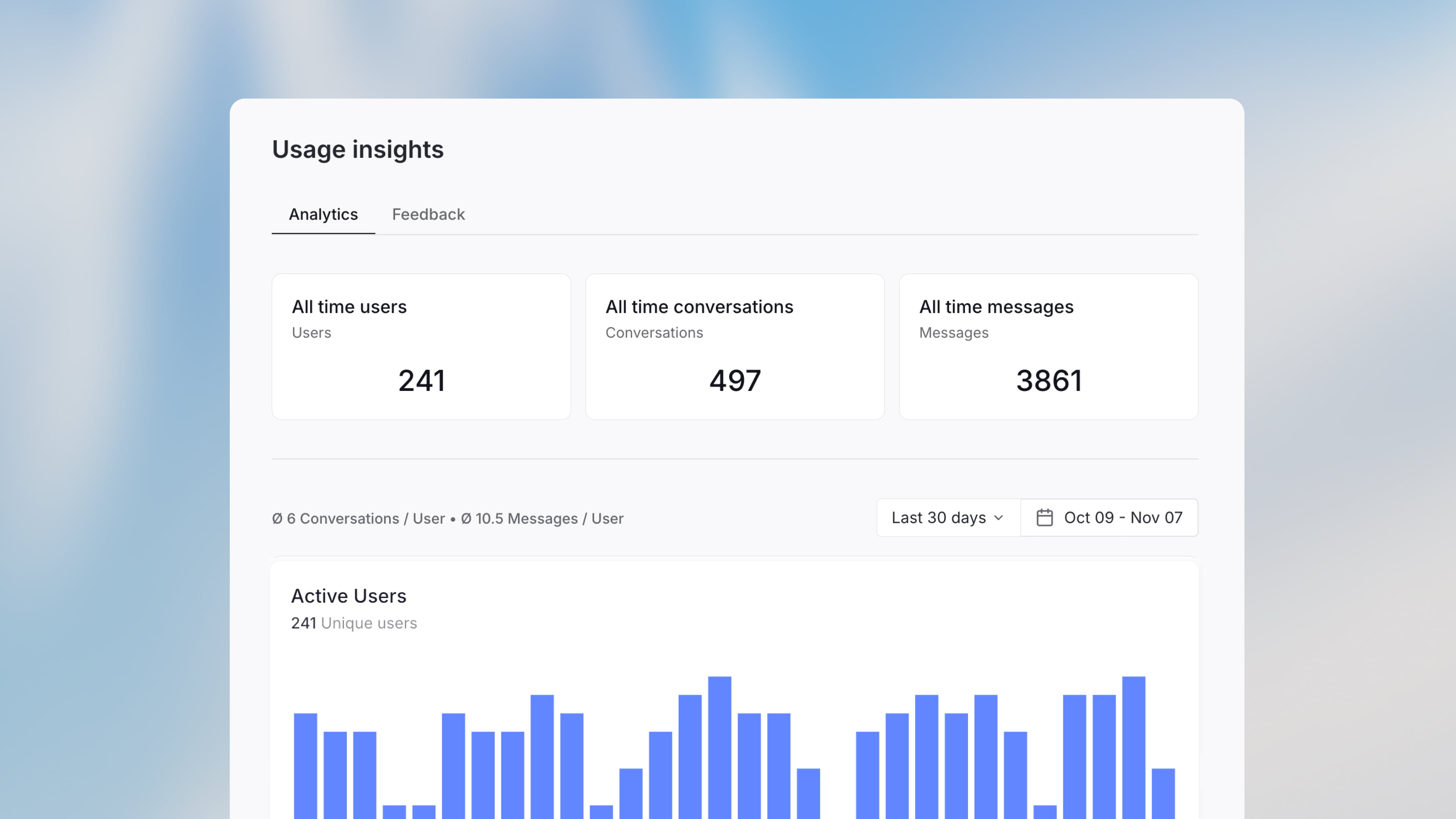

Assistenten Analytics

Erhalte wertvolle Erkenntnisse in die Nutzung deiner Assistenten mit der neuen Funktion für Nutzeranalysen in Langdock.

Nutzer können jetzt Antworten mit Daumen hoch oder runter bewerten und Kommentare hinterlassen. Das ermöglicht direktes Feedback, das dir helfen kann, die Konfiguration deines Assistenten zu verbessern. Diese Interaktion verbessert das Nutzererlebnis und bietet konkrete Verbesserungsvorschläge im Feedback-Tab.

Im Analyse-Tab kannst du als Bearbeiter oder Besitzer eines Assistenten auf quantitative Daten zur Nutzung über bestimmte Zeiträume zugreifen. Die Anzahl der Nachrichten, Konversationen und Nutzer hilft dir, das Nutzerengagement zu verstehen und Bedürfnisse zu erkennen.

Mit diesen Erkenntnissen können Assistenten-Ersteller die Qualität evaluieren und fundierte Verbesserungen an der Konfiguration vornehmen, was zu einem effektiveren und benutzerfreundlicheren Assistenten führt.

- Kleinere Verbesserungen am Canvas: Wir haben das Verhalten und Darstellung auf Mobilgeräten verbessert, die Streaming-Animation läuft jetzt flüssiger und das Modell mit Canvas aktiviert die Canvas-Funktion zuverlässiger.

- Neues Dateiformat: Wir haben Unterstützung für .eml-Dateien hinzugefügt.

- Geteilter Bildschirm anpassen: Der geteilte Bildschirm für Canvas und der geteilte Bildschirm für den Assistenten können jetzt horizontal durch Ziehen der Grenze in der Mitte angepasst werden.

- Höheres Dateilimit von Bilddateien: Es können jetzt mit bis zu 20 MB hochladen.

Canvas

Einführung von Canvas

Wir freuen uns, Canvas vorzustellen – ein neues Feature in Langdock, das Schreib- und Coding Aufgaben einfacher macht. Canvas bietet eine interaktive Oberfläche, in der Texte und Codes direkt mithilfe von KI bearbeitet werden können.

Highlights:

- Inline-Bearbeitung: Einfaches Bearbeiten und KI-Vorschläge erhalten.

- Codierungstools: Code überprüfen und Fehler beheben.

- Schreiberweiterungen: Ton und Stil des Textes leicht anpassen.

Canvas ist jetzt für alle Langdock-Nutzer verfügbar.

- Benutzerdefinierte Embedding-Modelle für Vector DB: Beim Verbinden mit benutzerdefinierten Vector-Datenbanken können Benutzer jetzt konfigurieren, welches Embedding-Modell für die Umwandlung der Suchanfragen verwendet werden soll.

- Such-Endpunkt für Wissensordner hinzugefügt: Unsere Wissensordner-API wurde noch nützlicher gemacht, mit der einfachen Möglichkeit, durch hochgeladene Inhalte zu suchen.

- Die maximale Länge für das Prompt-Eingabefeld wurde auf 120.000 Zeichen erhöht.

- Verbesserungen der Scroll-Stabilität bei der Generierung von Antworten: Streaming & Scrollen ist jetzt suuuuuper flüssig...

- Funktion „Zugriff anfordern“ für Arbeitsbereiche hinzugefügt: Verbesserung des Onboarding-Prozesses für neue Benutzer und Administratoren.

- Konsistente Breadcrumb-Navigation auf allen Unterseiten im Produkt.